人工智能:不要开发致命性自主式武器

majer @ 2018.08.02 , 10:00 上午

人工智能(AI)可以帮助我们预测自然灾害、甄别犯罪行为和寻找拐卖人口、诊断致命疾病来拯救生命。不幸的是,它也有可能变成杀人的武器。

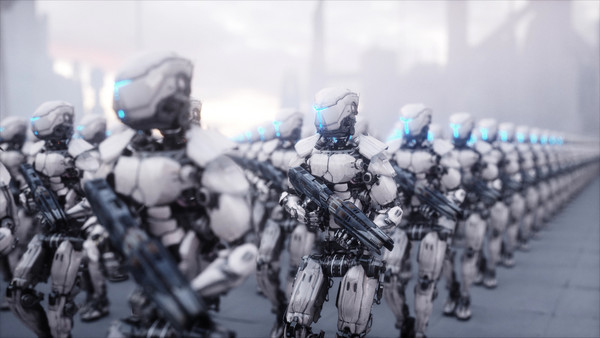

致命性自主武器——人工智能自行决定是否杀死锁定对象的武器——的研发已经在进行中了。

7月中的一个周三,未来生命研究所(FLI)——一家专注于利用科技改善人类的组织——发布了一项声明,即谴责致命的自主武器的发展,并呼吁各国政府禁止这样的研究。

“人工智能拥有使世界更加美好的巨大的潜力——如果我们人类有起码的廉耻心,拒绝滥用它们的话。”FLI总裁Max Tegmark在新闻稿中说。

“能够自主决定杀人的人工智能武器与生物武器一样令人厌恶和不安全,应该对它们一视同仁。”

一百七十个组织和2464人签署了倡议书,承诺“既不参与也不支持致命自主武器的开发、制造、贸易或应用”。

该承诺的签署者包括OpenAI创始人Elon Musk,Skype创始人Jaan Tallinn和AI领域的领导者Stuart Russell。

Google DeepMind的三位联合创始人(Demis Hassabis,Shane Legg和Mustafa Suleyman)也签署了这一承诺。 DeepMind是谷歌最重要的人工智能研究团队,该公司最近因与美国国防部合作而陷入到舆论的风口浪尖,公司内部对其未来的发展方向产生了巨大的分歧。

今年6月,谷歌发誓不会续签国防部的合同,后来又发布了人工智能开发的全新指导方向,其中包括禁止自主式武器。

签署FLI承诺书可以进一步确立该公司自身对致命自主武器的公开立场。

目前尚不清楚该承诺是否会引发其他具体的实际行动。

联合国二十六名成员国已经同意在全球范围内禁止使用致命的自主武器,但包括俄罗斯,英国和美国在内的一些世界领导人尚未表态。

这已不是AI专家们第一次聚集在一起发出反对开发自主武器的倡议。然而,这次的承诺书确实引来了更多的签名者,其中包括几位在业内鼎鼎大名的人物。

不幸的是,即使世界上所有国家都同意禁止研发致命的自主武器,它也无法阻止个人和某些政府继续秘密研制AI武器。

我们即将推开新时代的大门,AI将成为人类事务和生活中的重要组成部分,看起来我们别无选择,只能希望聪明的好人总能战胜坏人。

本文译自 sciencealert,由 majer 编辑发布。

PREV : 日本开发出应对核污染事故的AI

NEXT : “长大后,我终于为自己而活了”