Stable Diffusion 3发布后,因生成的畸形人体图像被网友嘲讽为“倒退”,引发广泛讨论。

在周三,Stability AI发布了Stable Diffusion 3 Medium,一种将文本提示转换为AI生成图像的模型。但该模型因生成的人体图像畸形,反而被网友嘲笑为技术上的倒退,与其他先进的图像合成模型如Midjourney或DALL-E 3相比显得逊色。因此,该模型很容易生成解剖结构不正确的视觉畸形图像。

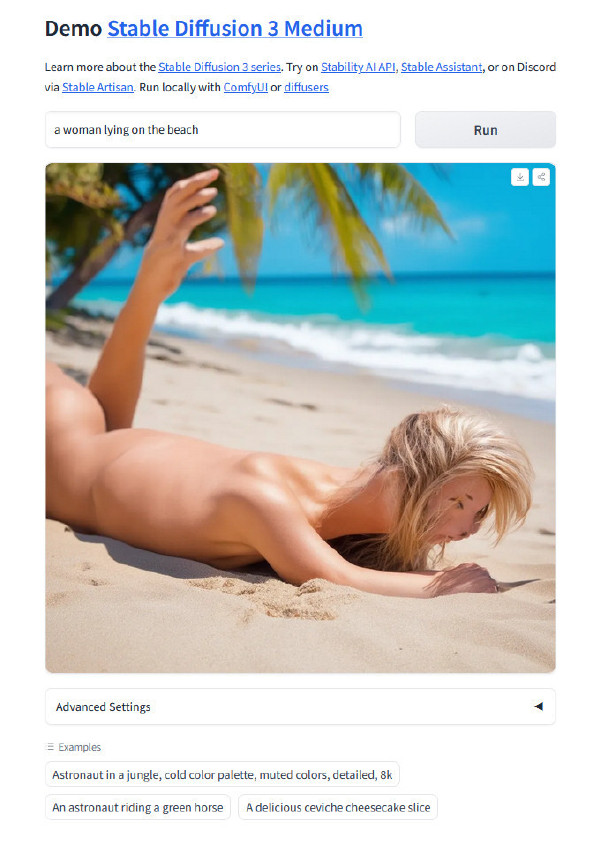

在Reddit上,一个名为“Is this release supposed to be a joke? [SD3-2B]”的帖子详细描述了SD3 Medium在渲染人类,特别是人类四肢如手和脚方面的显著失败。另一个名为“Why is SD3 so bad at generating girls lying on the grass?”的帖子则展示了整个身体的类似问题。

传统上,AI图像生成器在生成手部图像时一直面临挑战,因为早期训练数据集中的好例子不足。但最近,几个图像合成模型似乎已经克服了这个问题。从这个意义上说,SD3对聚集在Reddit上的图像合成爱好者来说,似乎是一个巨大的倒退,尤其是与去年11月发布的SD XL Turbo相比。

“StableDiffusion曾与Midjourney竞争,现在它看起来就像个笑话。至少我们的数据集是安全和伦理的!”一位Reddit用户写道。

AI图像爱好者将Stable Diffusion 3的人体解剖失败归咎于Stability坚持从SD3训练数据中过滤掉成人内容(通常称为“NSFW”内容)。一位Reddit用户在帖子中写道:“相信与否,严格审查模型也会去除人体解剖内容,所以……这就是发生的事情。”

基本上,每当用户提示集中在AI模型训练数据集中未能很好代表的概念时,图像合成模型将会尽力解释用户的要求。而有时,这会变得非常可怕。

2022年发布的Stable Diffusion 2.0也曾在描绘人类方面出现类似问题,AI研究人员很快发现,审查包含裸体的成人内容会严重阻碍AI模型生成准确的人体解剖能力。当时,Stability AI通过SD 2.1和SD XL逆转了这一过程,重新获得了一些因强烈过滤NSFW内容而失去的能力。

另一个在模型预训练期间可能出现的问题是,有时研究人员用来移除数据集中成人图像的NSFW过滤器过于苛刻,意外移除了可能并不冒犯的图像,剥夺了模型对某些情况下人类形象的描绘。

“[SD3]只要图片中没有人类就没问题,我认为他们改进的nsfw过滤器决定任何类人形象都是nsfw,”一位Reddit用户在该话题中写道。

我们在Hugging Face上使用免费的SD3在线演示,运行提示并看到了与其他人报告类似的结果。例如,提示“一个男人展示他的手”返回了一张男人举起两只巨大的反手的图像,尽管每只手至少有五个手指。

Stability公司的困境

Stability在二月宣布了Stable Diffusion 3,并计划将其提供为各种模型大小。今天发布的是“Medium”版本,一个拥有20亿参数的模型。除了在Hugging Face上提供的权重外,它们还可以通过公司的Stability Platform进行实验。这些权重可以免费下载和非商业用途使用。

在二月宣布之后,SD3模型权重的发布延迟引发了关于技术问题或管理不善的谣言。Stability AI作为公司最近陷入困境,其创始人兼CEO Emad Mostaque在三月辞职,随后进行了一系列裁员。在此之前,三位关键工程师——Robin Rombach、Andreas Blattmann和Dominik Lorenz——离开了公司。其困境可以追溯到更早,2023年以来,公司财务状况不佳的消息一直在流传。

对于一些Stable Diffusion的粉丝来说,Stable Diffusion 3 Medium的失败是公司管理不善的视觉体现,明显显示出公司状况恶化的迹象。尽管公司尚未申请破产,但在看到SD3 Medium后,有些用户开了黑色幽默的玩笑:

“看来现在他们可以在安全且合伦理的方式下破产了”

尽管如此,Stability AI仍在努力通过改进和发布新的模型来克服这些挑战。对于AI图像合成爱好者和研究人员来说,模型的每一次进步和每一次失败都是技术发展的重要一环。随着技术的不断发展和数据集的不断改进,未来的AI图像生成模型可能会更好地处理这些问题。

本文译自 Ars Technica,由 BALI 编辑发布。