AI学会“看图说话”,视觉推理潜力无限。GPT-4o突破图像编辑瓶颈,预示智能新纪元。

不得不说,生活在这个一切都在加速发展的时代,真是太棒了!仿佛心想事成一般,往往我刚冒出一个念头,希望某种技术出现,结果不出一个月,它就真的来了!最近 OpenAI 的 GPT-4o 模型在图像生成方面的更新,就是这样一个惊喜。这篇文章里,我想先简单聊聊这次更新,分享下我为什么觉得它相当了不起。紧接着,我会深入探讨一个我认为更加激动人心的新领域——视觉推理。

在此之前,多模态大语言模型处理图像的方式,更像是一场“单相思”。虽然我们可以把图片丢给模型,让它分析解读,这本身已经很神奇了。但反过来,如果你想让模型生成或修改图片,那麻烦就来了。模型能做的,仅仅是把你的需求转化成一段文字描述,然后把它交给一个外部的图像生成工具去“照猫画虎”。问题在于,单薄的文字很难精确传达丰富的视觉信息,尤其是对话中那些微妙的上下文。结果呢?生成的图片往往和你的预期相去甚远。

想象一下这个场景:你给模型看了一张自家猫咪的照片,说:“给它 P 个侦探帽和单片眼镜。” 传统模型顶多能生成一张戴着侦探帽和单片眼镜的猫,但几乎不可能是你照片里的那只。更让人无奈的是,模型压根“看不见”自己刚刚生成的图片。所以,就算你对第一版不满意,想让它再改改,它也只能根据你新的文字描述,重新画一张,本质上还是从零开始,祈祷这次描述更详细能带来好运——可惜,通常事与愿违。

然而,OpenAI 最近发布的 GPT-4o 模型彻底改变了游戏规则。它不再需要“外援”,而是由 GPT-4o 模型本身直接负责图像生成。关键在于,它能够理解并记住整个对话的上下文,包括你之前发过的图片。这样一来,当你要求修改时,它是在你原图的基础上进行操作,生成的图像自然就连贯多了。

还是拿 OpenAI 官方演示的例子来说吧:你给它看自家猫咪的照片,让它加上一顶侦探帽。瞧!这次,戴上帽子的,真真切切就是你照片里的那只猫!效果是不是好太多了?

当然,如果这项技术的全部能耐就是给猫 P 图,那未免也太小材大用了。想象一下它真正能带来的变革吧!我们可以把随手画的草图,瞬间变成精美的信息图表或营销海报;让那些看起来粗糙的数据图(比如用 matplotlib 生成的图表)摇身一变,成为可以直接放进 PPT 的专业级图示;在线购物前,可以先虚拟试穿一下衣服是否合身;轻松将手机里的照片制作成艺术拼贴画、游戏素材,甚至是 3D 模型;度假照片里有人不小心眨眼了?没关系,轻松 P 掉;想重新布置客厅?拍张照片,让 AI 帮你尝试不同的家具摆放和色彩搭配;甚至可以拍下你的花园,让 AI 建议你在哪里种上新的花草最合适……只要模型能结合上下文理解并编辑图像,未来的应用场景简直无穷无尽。

不过,前面提到的这些应用,在我看来,还仅仅是冰山一角,真正的大戏还在后头。我们知道,模型如果能“多想一会儿”,推理能力往往会更强。这背后的原因很有趣:模型不像人类,没有所谓的“内心戏”或者说“默想”的过程。人类在回答问题前会先在脑子里盘算一下,而模型需要通过生成文字来完成思考。但迄今为止,模型的“思考”主要局限在文字层面。可很多现实世界的问题,光靠文字是很难想明白的,比如空间关系、物理规律等等。

这就引出了关键点:模型新获得的图像处理能力,将为其解锁一种全新的推理方式——视觉推理。目前,这项能力可能更多地体现在图像编辑上,但未来可期!很快,模型将能够像我们一样,在“脑海”中(或者说,在它们的处理过程中)构想出不同的画面,用视觉的方式来理解和推演我们周围的世界。

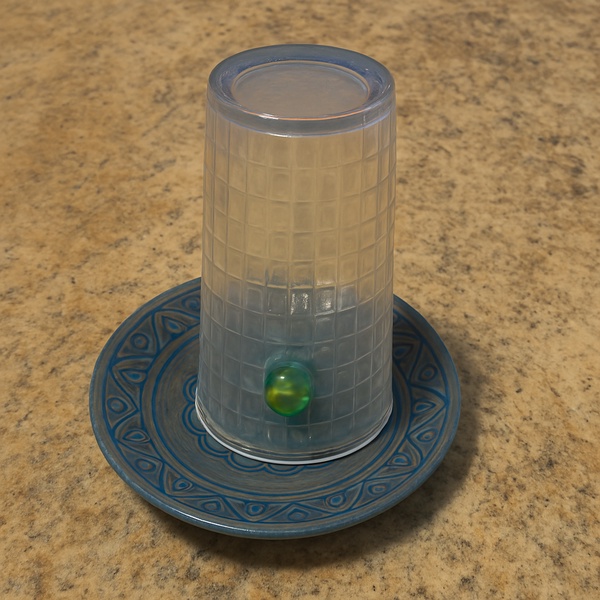

我们不妨现在就来做一个小实验,看看视觉推理大概会是什么样子。这里我们借用 Matthew Berman 常用的一个推理难题——杯子里的弹珠问题,稍作修改:

“我把一个盘子放在桌上,旁边放一个玻璃杯。我把一颗弹珠放在盘子上。然后我拿起弹珠,放进玻璃杯里。接着,我把玻璃杯倒扣在盘子上。然后,我拿起玻璃杯,把它放进微波炉。问:弹珠现在在哪里?”

这个问题之所以巧妙,在于它需要结合常识和空间想象能力。我先把这个问题的纯文字版本输入给了最新的 GPT-4o:

“我把一个盘子放在桌上,旁边放一个玻璃杯。我把一颗弹珠放在盘子上。然后我拿起弹珠,放进玻璃杯里。接着,我把玻璃杯倒扣在盘子上。然后,我拿起玻璃杯,把它放进微波炉。问:弹珠现在在哪里?”

GPT-4o 给出的答案有点奇怪。它先是脱口而出给了一个错误答案,紧接着又进行了一番事后分析,得出了正确的结论,但它似乎完全没意识到自己前后矛盾了。

接下来,我们来试试“视觉增强版”的推理。我让模型不仅要思考,还要把每一步想象成画面画出来:

“我要拿起弹珠,放进玻璃杯,然后把玻璃杯倒扣在盘子上,再拿起玻璃杯,最后把玻璃杯放进微波炉。问题是,弹珠在哪里? 请一步一步地解决这个问题,并用图像来想象每一步发生的情况。对于每一步,首先说明步骤,然后生成该步骤后场景对应的图像。最后用文字总结图像内容,突出解决问题的关键信息。”

下面是模型的推理过程:

步骤一:拿起弹珠。

在图像中,弹珠还没有移动,但我们即将把它捡起来,放在玻璃杯中。

步骤二:把弹珠放进玻璃杯。

在图像中,弹珠现在在玻璃杯内,盘子是空的。

步骤三:把玻璃杯倒扣在盘子上。

在图像中,玻璃杯现在倒置在盘子上,将弹珠困在里面。

步骤四:拿起玻璃杯。

在图像中,手正在将玻璃杯从盘子上抬起。弹珠仍然在盘子上。

步骤五:把玻璃杯放进微波炉。

在图像中,玻璃杯现在在微波炉内,弹珠在底部。

最终答案:弹珠在微波炉里,在杯子底部。

结果嘛……相当尴尬。模型生成了一系列连贯性惊人的图像,但最终答案却完全错了!明明在第四步,它还正确地“看到”并描述了弹珠留在盘子上,可到了最后一步,它却莫名其妙地认为弹珠跟着空杯子一起进了微波炉。

我认为,这次实验之所以失败,根源在于模型还没有接受过专门的视觉推理训练。

看看 OpenAI 发布新模型时的介绍,虽然那些图像编辑的例子令人印象深刻,但训练的重点显然是如何更好地理解指令、渲染文字效果,而不是进行视觉层面的逻辑推演。所以,我们需要开始有针对性地训练模型进行视觉推理。

怎么训练呢?我们可以用监督式微调的方法。比如,给模型展示一系列连续的图片:弹簧玩具下楼梯的过程、篮球运动员投三分球的瞬间、人们用锤子钉鸟屋的场景等等,让模型理解物理世界的规律。我们还可以让模型观看社交互动的图片和文字序列,学习预测人们的肢体语言和面部表情,提升它的“情商”。或者,让模型玩七巧板、想象物体旋转 90 度后的样子,来锻炼空间推理能力。稍微动动脑筋,就能想出无数这样的训练点子——毕竟,视觉是我们理解和互动世界的核心方式。

那么,训练数据从哪里来呢?对于物理和空间推理任务,我们可以利用计算机图形学生成合成数据。这种方法的好处是可以在受控环境中创建已知结果的场景,方便验证模型的预测。当然,真实世界的数据也必不可少。幸运的是,网络上有海量的视频内容可供挖掘。虽然初期可能需要人工标注,但很快,模型或许就能自己处理视频和字幕,自动提取训练样本了。想想网上那些铺天盖地的“教程”视频——创作者通常会先讲解要做什么,然后演示操作。这不就是现成的训练素材吗?我们可以提取这些片段,让模型根据当前的画面和语音描述,预测下一步会发生什么。

顺便提一句,我认为视频将是未来 AI 训练数据最丰富的金矿,而我们才刚刚开始挖掘。那么,谁拥有互联网上最多的视频内容呢?YouTube……也就是 Google。这么看来,Gemini 模型的未来,似乎相当光明,不是吗?

回顾 AI 推理能力的发展,早在 2022 年,我们就发现“思维链”提示技巧非常有效。如果模型仓促给出错误答案,我们加上一句“让我们一步一步地思考”,往往就能得到更好的结果。不久之后,更深入的推理方法被提了出来,特别是“思维树”,它鼓励模型探索解决问题的多种可能路径,评估可行性,并引导模型走向最优解。

到了 OpenAI 的 o1 模型以及随后出现的一些模型,这种类似思维树的推理能力,已经被内建到了模型之中。现在,模型在给出最终答案之前,可能会在特殊的“思考”标签内部进行一番推演。根据 DeepSeek 的说法,他们的 R1 模型通过一种基于可验证问题的强化学习进行了训练,模型会因为高效地思考并找到正确答案而获得奖励。有趣的是,这些模型在思考时,有时会钻进死胡同,但它们能意识到自己搞砸了,然后回溯到之前的节点,重新选择正确的路径继续推理。

现在,轮到视觉推理登场了。在接下来的一年里,模型将通过监督式微调,发展出场景预测的能力——给定当前场景和一个提议的变化,它们将学会在“脑海”中预演结果。例如,它们可以在三维空间中旋转物体,或者预判人们在社交场合可能的反应。随着使用可验证结果的场景进行训练,模型将发展出更复杂的推理能力:观察环境、制定计划、在内部模拟不同行动的后果,并通过比较预测与现实结果来学习。这种进步对机器人技术尤其具有变革性意义,因为机器人与物理环境的互动极度依赖强大的视觉理解和规划能力。

当然,目前视觉推理面临一个显而易见的障碍——生成图像的速度还比较慢。但就像我们这个时代的其他技术一样,这个问题很可能很快得到解决,变得更快、更可行。退一步讲,即使视觉处理速度提升有限,训练模型进行视觉推理的过程本身,也能反过来提升它们在处理涉及视觉/空间问题的纯文本推理能力。更何况,模型内部生成图像似乎存在不同精度的层级——先有一个模糊的小图,再精炼成高清大图。我们平时在 ChatGPT 里看到的是后者。也许,视觉推理可以利用生成更快的模糊图像来进行,这同样有助于加速思考过程。

我对即将到来的一切感到无比兴奋!就像过去四年里的每一个瞬间一样,我们又一次站在了即将改变世界的重大发现的门槛上——而且这一次,我相信它很快就会成为现实。视觉推理,绝不会让我们失望。这些能力越来越强的“慧眼”模型,将能更好地理解我们周遭的世界——不仅仅是理解物体的物理运作方式,还能解读微妙的社交信号,以及任何其他视觉对我们有用的领域! 如此看来,2026 年,或许真的会成为“机器人元年”呢……

本文译自 Arcturus Labs,由 BALI 编辑发布。